Теория:

Интерполяция, или интерполирование (происходит от латинского inter–polis — «обновлённый, преобразованный»), представляет собой метод в области вычислительной математики.

Который позволяет вычислять неизвестные значения между заданными точками функции на основании существующего дискретного набора известных значений.

Данный термин был впервые введен в научный обиход Джоном Валлисом в его работе «Арифметика бесконечных», опубликованной в 1656 году.

Интерполяция используется для приближенного определения значений функции в промежуточных точках, что особенно полезно в ситуациях, когда невозможно или слишком затратно провести измерения.

Существует множество методов, включая линейную и полиномиальную, каждый из которых имеет свои особенности и области применения.

Часто случается, что обычные четырехзначные таблицы не дают непосредственно значение логарифма с принятой точностью, и поэтому приходится совершать дополнительное действие.

Пример решения:

Логарифм числа 283,4 не содержится непосредственно в таблице. Четвертая слева цифра — 4 составляет 4/10 от разности чисел 283,0 и 284,0.

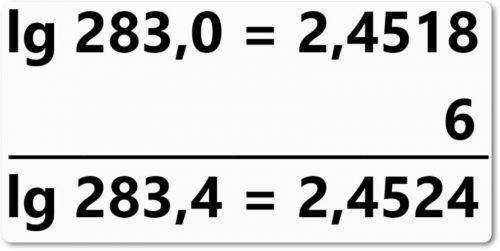

В таблице разности между соседними логарифмами табулированы, и, обращаясь к таблице, находим:

lg 283,0 = 2,4518,

а разность (по отношению к lg 284,0) оказывается равной 15. Поэтому для получения lg 283,4 прибавляем к lg 283(4/10) от 15.

Итак:

Следует всегда помнить, что с увеличением возрастает и логарифм, а потому, если искомое число больше данного в таблице, то разность должна быть прибавлена к последнему.